Ineffizientes Kamera-Processing

Die

Ursache für schwächelnde Performance, trotz

hochwertiger Hardware, ist scheinbar immer die gleiche

...

Wenn

erst nach dem vierten Firmware-Update aktuelle Kameramodelle

nicht mehr wie eine Kaffeemaschine funktionieren,

sondern tatsächlich zuverlässig gute Bilder

machen, dann sind die Ursachen unverkennbar. Zu kurze

Entwickungs- und Testzeiten, zu schnelle Marktpräsenz,

zu harte Kostenminimierung beim Personal, aber auch

taktische Technik-Tricks zum marktstrategischen Vorteil

des geplanten Nachfolgemodells stehen dem entgegen.

Technisch informative Tests findet man bisher (2008)

"noch" bei dpreview

oder photozone

und bei Traumflieger.

Beispiele

für ineffizientes Processing ?

Typische

Beispiele für ineffizientes oder sensorunterforderndes

Processing findet man in den verschiedensten Preisklassen

und den verschiedensten Anwendungen. Von Labor-Kameras

(z.B. die TSC-350) bis zur DSLR (z.B. Canon, Nikon, Pentax

u.a.).

Nehmen

wir die Canon EOS 50D: Ein Modell aus der semi-Mittelklasse,

relativ preiswert, und dennoch mit hochwertiger Hardware

bestückt. Das Processing-Setup aber präsentiert

sich etwas unter Wert.  Aus

der Sorge das Signalrauschen könnte bei der medialen

Präsentation negativ auffallen, wurde das Processing-Setup

etwas zu weich abgestimmt, obwohl es nicht an qualitativer

Sensorauflösung fehlte und das befürchtete

Rauschen auch von namhaften Testern nicht als besonders

auffälliges Problem diagnostiziert wurde. Im

Vergleich zum Vorgängermodell 40D (22.2x14.8mm,

5.7Ám, 3888 x 2592, 10.1MP) erreicht die 50D (22.3x14.9mm,

4.7Ám, 4752 x 3168, 15.1MP) nur gerade mal 11 bis

16% mehr Detailauflösung an einer Standard-Optik.

Rein rechnersch ist dieses Ergebnis etwa die Hälfte

dessen, was sein müßte. Eine Sensorik in

dieser Dimenson und Auflösung war Neuland und

in so kurzer Entwicklungszeit durchaus ein Risiko.

Einige Test-Maganzine führten den Auflösungsverlust

auf die Microlinsen zurück, aber dieses Verfahren

war schon bei Vorgangäger-Modellen erprobt. Die

gewichtige Ursache ist das Processing und die Standard-Optik.

Mit anderem Processing und einer Optik aus der Premium

EF L-Serie ist die Abbildungsqualität deutlich höher

und entspricht dann der Sensorauflösung (Fläche, Distanz,

Anzahl). Der Unterschied im Ergebnis zeigt eine Reserve,

die bei der 4.7Ám Pixeldistanz scheinbar von Standard-Optik

schon nicht mehr über alle Blenden genutzt werden

kann. Diese Kamera erzwingt also hochwertigere Optik,

will man die theoretisch gebotene Auflösung ausnutzen. Aus

der Sorge das Signalrauschen könnte bei der medialen

Präsentation negativ auffallen, wurde das Processing-Setup

etwas zu weich abgestimmt, obwohl es nicht an qualitativer

Sensorauflösung fehlte und das befürchtete

Rauschen auch von namhaften Testern nicht als besonders

auffälliges Problem diagnostiziert wurde. Im

Vergleich zum Vorgängermodell 40D (22.2x14.8mm,

5.7Ám, 3888 x 2592, 10.1MP) erreicht die 50D (22.3x14.9mm,

4.7Ám, 4752 x 3168, 15.1MP) nur gerade mal 11 bis

16% mehr Detailauflösung an einer Standard-Optik.

Rein rechnersch ist dieses Ergebnis etwa die Hälfte

dessen, was sein müßte. Eine Sensorik in

dieser Dimenson und Auflösung war Neuland und

in so kurzer Entwicklungszeit durchaus ein Risiko.

Einige Test-Maganzine führten den Auflösungsverlust

auf die Microlinsen zurück, aber dieses Verfahren

war schon bei Vorgangäger-Modellen erprobt. Die

gewichtige Ursache ist das Processing und die Standard-Optik.

Mit anderem Processing und einer Optik aus der Premium

EF L-Serie ist die Abbildungsqualität deutlich höher

und entspricht dann der Sensorauflösung (Fläche, Distanz,

Anzahl). Der Unterschied im Ergebnis zeigt eine Reserve,

die bei der 4.7Ám Pixeldistanz scheinbar von Standard-Optik

schon nicht mehr über alle Blenden genutzt werden

kann. Diese Kamera erzwingt also hochwertigere Optik,

will man die theoretisch gebotene Auflösung ausnutzen.

Ein

Test zum selber machen: Das Rauschsignal ist

u.a. zeit- und temperaturabhängig. Es verstärkt

sich bei längeren Belichtungszeiten, mit höherer

Lichtempfindlichkeit (ISO-Werte, Offset-Level) und

der permanente Stromfluß läßt die

Temperatur weiter steigen. Darum sollte man beim Testen

die Betierbstemperatur (Betriebszeit, Stromaufnahmezeit)

vergleichbar berücksichtigen, eine gleichwertige

Optik verwenden und für gleiche Belichtungsbedingungen

sorgen.

Die

Testbedingungen sollten unkompliziert und gut vergleichbar

sein. Man stellt den Kamera-Modus auf Av (Belichtungszeit

justiert die Kamera automatisch), setzt den ISO Wert

auf 800 und die Blende auf 4. Bei neutraler und gleichmäßiger

Ausleuchtung, in einer Entfernung von 5 Meter lichtet

man mehrfach eine geeignete Testtafel ab. Bei diesen

einfachen Vorgaben läßt sich das Störungsrauschen

und die Abbildungsqualität schon beurteilen.

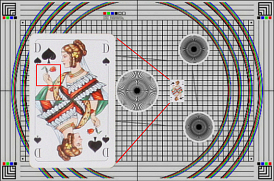

|

| Ausschnitt

aus dem Testbild, nahe am Zentrum |

|

|

|

|

| Das

Rauschen bleibt bei der 50D im Rahmen der realistischen

Erwartung relativ gering. Man erkennt jedoch bei

ISO 800 die zerfließenden Konturen, trotz

hochwertiger Sensorik. |

|

Dieses

Ergebnis wäre möglich gewesen. Der markante

Informationsgehalt ist bereinigt und optimiert.

|

Ein

moderat eingestellter Image-Cleaner generiert zwar

keine neuen Detail, stellt aber die vorhandenen Konturen

besser heraus. Diese Abbildungsleistung (rechts) könnte

das Hardware-Processing der 50D realisieren und man

sieht bei der Gegenüberstellung: Eine höhere

Abbildungsschärfe ist tatsächlich vorhanden,

die aber offensichtlich nicht optimal ausgesteuert

wird. Es gab mehrere Firmwareupdates, die jedoch hatten

wohl mehr zum Ziel einige Fehler der Bedienungslogik

zu beheben.

Anderes

Beispiel ? Die Pentax K20D ist ebenfalls ein hochwertiges

Kameramodell, das zudem im Preisvergleich

etwas günstiger zu erwerben ist. Hier war es

genau umgekehrt: Offensichtlich wollte man der Konkurrenz

inpunkto Auflösung mal zeigen,  wo

der Hammer hängt und definierte für die

K20D eine (zu) harte Aussteuerung der Schärfe

bei folglich stärkerem Rauschen. Unter gleichen

Bedingungen (ISO 800, Blende 4, Belichtungszeit durch

Ausleuchtung justiert) zeigt sich das Problem in den

Testbildern. wo

der Hammer hängt und definierte für die

K20D eine (zu) harte Aussteuerung der Schärfe

bei folglich stärkerem Rauschen. Unter gleichen

Bedingungen (ISO 800, Blende 4, Belichtungszeit durch

Ausleuchtung justiert) zeigt sich das Problem in den

Testbildern.

Für

Fehler dieser Kategorie sind meistens nicht die vermeindlich

"großen" Unterschiede in der Sensorik

verantwortlich, zumal nicht nur Nikon heute die Sensorik

für ihre Mittelklasse schon von Fremdherstellern

kauft, und dennoch hatte Nikon zu dieser Zeit noch

mit weniger Problemen im Processing zu kämpfen,

was eine hochwertigere Abstimmung beweist.

Die

K20D ist agressiver justiert als die Vergleichsmodelle

von Canon oder Nikon. Trotzdem kann man nicht behaupten,

daß dieses Modell gegenüber der Konkurrenz

gravierend benachteiligt wäre.

|

|

|

| Störungsrauschen

der K20D auf ebenen Flächen und beginnendes Oversharpening

bei ISO 800. |

|

Dieses

Ergebnis wäre möglich gewesen. |

Justiert

man die Schärfe herunter, dann produziert auch

diese Kamera sehr detailierte und dennoch gleichmäßig

konturierte Bilder, was ausreichende Hochwertigkeit

der Hardware belegt. Senkt man den ISO-Wert noch etwas ab, dann

ist der Rauschenanteil ebenfalls mit der Konkurrenz vergleichbar.

Ein nachträgliches Processing kann auch hier einiges

bewirken. Interessant ist die sichtbar andere Farbwertung

der 50D im Vergleich zur K20D. Die Pentax bewertet

+10/255 bis +15/255 Magantaanteile über Neutral,

die Canon zeigt eine ähnliche Abweichung im Grünberech.

Leider

war kurzfristig keine Nikon D300 verfügbar. Sie

hätte ergänzend zeigen können, was

ein gutes Processing in dieser Preisklasse ausmacht,

bei sogar etwas kleinerer Pixelmatrix. Die Nikon D300 ist

in der Auswahl der Hardwarekomponenten nicht hochwertiger,

aber offensichtlich wurde das Processing sorgfältiger

kalibiert, denn die effektive Output-Auflösung

kann erstaunlicherweise mithalten. Seit neuem ist

bei Nikon geplant Sensorik im Auftrag fertigen zu lasssen,

sodaß sich zukünftig wohl die Folgen "moderner

Marketing-Strategien" auch bei Nikon bemerkbar machen

könnten.

Und

wer glaubt Kameras mit zweifachem Kaufpreis und größerer

Leistungsreserve hätten derartige Probleme nicht

mehr, der sollte nicht "glauben", sondern selbst testen.

Die Beurteilung der Sensor- und Processing-Qualitäten

bedarf nicht unbedingt der "aufwändigen

Labortechnik", meistens reichen schon Aufmerksamkeit

und der konkrete Vergleich. Werbendes Mediengeschätz

darf und sollte man kritischer wahrnehmen. Nur die

Kamera-Hersteller der namhaften Premium-Klasse können

sich solche Scherze nicht leisten (realistische Tests

sind dennoch angebracht) ohne die eigene Geschäftgrundlage

nachhaltig zu beschädigen, denn hier geht es

nicht nur um andere Preiskategorien, um andere Kunden

mit anderen Erwartungen, sondern um einen über

mehrere Jahrzehnte mühsam erarbeiteten Qualitätsanspruch.

Bei

unvorteilhafter Setup-Justierung oder Setupfehlern

ist es nicht zwingend notwendig in ein neues oder

größeres Modell investieren zu müssen,

sofern die Grenzen der Bildqualität nicht unterschritten

werden. Ein Post-Processing per PC und Software kann

immer gefahrlos die Bildqualität verbessern,

ohne die Garantie des Herstellers riskieren zu müssen

- beim "Chiptuning"

oder beim Installieren einer modifizierten "Selbst-Compilation"

(Firmware-Eigenbau) wäre sie möglcherweise

verspielt. Gegen suboptimales Sensor-Setup hilft externes

"Image-Processing", also das Programmieren

von Korrektursystemen. Wer sich für weiterführende

Infos zu dieser Theamtik interessiert, der schaut

in den Termin-Planer oder in

die Sirius5-Archive.

gecco-031, tw-017

[ weiter

... ]

|