DIGITAL IMAGING

Digital-Imaging

ist der Sammelbegriff für visualisierende Digitaltechnik mit den

Bestandteilen Material-Wissenschaft, Chiparchitektur, Modul-Design und

Programmierung (Image-Processing). Optische Sensorik und Digital-Imaging

zählen zu den Schlüsseltechnologien, die im letzten Jahrzehnt sehr

an Aufmerksamkeit gewinnen konnten. Hinter diesem trendigen Begriff steht

ein langer Weg technologischer Evolution.

Ohne die komplexen

Phänomene der Physik, ohne die Halbleiter-Technogie und die praktische

Anwendung der Photonenwechselwirkungen in Materie, wäre aktuelle Kamera-Sensorik

nicht realisierbar. Die photographische Visualisierung läßt sich in

Kürze nur dann darstellen, wenn aktuelle Technologien auf das wesentliche

Grundprinzip reduziert werden - einzige Vorausgesetzung für den kleinen

Schnell-Exkurs ist etwas motivierte Neugier. Beginnen wir daher nicht historisch,

nicht mit theoretischer Formalität, nicht im Nano-Universum der Atome und

Elektronen und auch nicht mit Adam und Eva.

Licht breitet sich in

Wellenform aus als räulich begrenzte Wellenpakete, den Lichtquanten oder

Photonen, und die Lichtstrahlen bestehen aus einem Strom vieler Photonen (den

Zeitaspekt lassen wir einfach mal weg). Jedes dieser merkwürdigen

Photonen transportiert Energie, im Vakuum haben sie alle die gleiche

Geschwindigkeit und ihre Frequenz ist proportional zur transportierten

Energie.

Wenn

Photonen in metallähnliche Materie "einschlagen"

und dort ihre Energie abgeben, dann lösen sie

freie Elektronen aus dem atomaren Verbund. Vergleichen

kann man das mit einem Apfelbaum. Wenn man den kräftig

schüttelt, dann werden die Früchte aus ihrem

zuvor festen Gefüge gerissen und in einen "frei

beweglichen Fallzustand" überführt,

wobei die Gravitation die Fallrichtung vorgibt.

Was beim fallenden Apfel die Gravitation ist, das

wird beim Elektron im Halbleiter durch ein ablenkendes

Ladungsfeld oder Potentialgefälle realisiert.

Die

"seismische Einwirkung" des einschlagenden

Photons mit entsprechender Energie generiert demnach

freigesetzte Elektronen, die mit einer "elektrischen

Gravitation" in ihrer Bewegung gelenkt werden

können. Die ausgelösten und nun frei beweglichen

Elektronen (siehe auch Photoeffekt) können so

einen fließenden Strom entstehen lassen und

mit dem geht eine meßbare Spannungsänderung

einher.

|

|

|

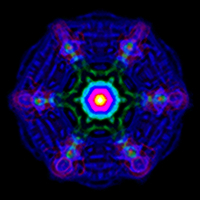

| Energetische Wirkungsverteilung in einem Halbleiter-Metall. |

|

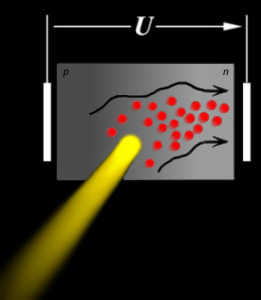

Freisetzung des Elektrons durch Photonen-Energie |

Der

Halbleiter, ein äuerst seltsames Metall, wie

beispielsweise Silizium, Germanium oder Gallium, verhält

sich ohne diesen "Meteoriteneinschlag" (Zuführung

von Licht-Energie) und ohne den in Folge ausgelösten

freien Elektronenstrom, wie ein sehr hoher Widerstand

(quasi-Nichtleiter) oder ein Stück Trockenholz.

Könnte man mit diesem Halbleiter die Lichtintensität

in eine elektrische Spannung oder einen Stromfluß

übersetzen, dann wäre auch ein digitales Auge

machbar.

Faule

Säcke, Besserwisser und unwirtschaftlich denkende

Menschen haben aus diesem seltsamen Halbleiter mit

Diamantstruktur eine Photodiode (PD) entwickelt. Wenn auf

diese Photodiode Licht (Photonen) trifft, dann beginnt

sie, abhängig von der Lichtintensität und

der Wellenlänge, zunehmend leitend zu werden

und es können freigesetze Elektronen transportiert

werden. Da PDs aus wenigstens zwei verschiedenen Halbleiterschichten

bestehen, einer p-dotierten und einer n-dotierten Schicht (eine

Schicht mit wenigen freien Elektronen und eine mit höherer

beweglicher Elektronendichte), kann

man

durch diesen pn-Unterschied ein

Potentialgefälle und damit eine Flußrichtung

vorgeben. Wie beim geschüttelten Apfelbaum die

Erdgravitation die Fallrichtung der Äpfel vorbestimmt,

so gibt das Potentialgefälle (die "elektronische Gravitation")

der Dotierungsschichten die Flußrichtung der Elektronen vor.

Mit einer äußeren angelegten Spannung kann man das

Potentialgefälle sogar steuern, um die durch

Lichtenergie freigesetzen Elektronen noch besser in

eine "bevorzugte" polare Richtung zu lenken. man

durch diesen pn-Unterschied ein

Potentialgefälle und damit eine Flußrichtung

vorgeben. Wie beim geschüttelten Apfelbaum die

Erdgravitation die Fallrichtung der Äpfel vorbestimmt,

so gibt das Potentialgefälle (die "elektronische Gravitation")

der Dotierungsschichten die Flußrichtung der Elektronen vor.

Mit einer äußeren angelegten Spannung kann man das

Potentialgefälle sogar steuern, um die durch

Lichtenergie freigesetzen Elektronen noch besser in

eine "bevorzugte" polare Richtung zu lenken.

Man

könnte die PD wie ein steuerbares Ventil beschreiben,

das nur bei Lichteinfluß in die bevorzugte Richtung

elektrisch durchlässig ist. Die vom Photoneneinschlag

aufgeschreckten Elektronen verhalten sich zuweilen

wie Politiker, denen man von links oder rechts mit

positiven Umfrageergebnissen und mit Fraktionszulagen

winkt - sie gehen den Weg des geringsten Widerstandes

und reagieren auf das Licht der Öffenlichkeit

sofort mit hektischer Betriebsamkeit. Das auftreffende

Licht in der PD generiert demnach nicht nur elektrischen

Strom, sondern es kommt zu einer richtungsorientierten

Ladungstrennung. Die PD ist damit nicht nur ein lichtgesteuertes

und regelbares Ventil, sie hat auch die Eigenschaft

eines Kondensators, der die Ladungsenergie speichert,

ähnlich wie ein Luftballon das eingepreßte

Füllgas.

Diese

Eigenschaften ausnutzend muß zur Wirkungsoptimierung

der Aufbau einer Photodiode so konstruiert sein, daß

einerseits eine möglichst große Lichtfläche

verfügbar ist, andererseits aber die verschiedenen

Halbleiterschichten ein hinreichend

starkes

Potentialgefälle erzeugen, womit Durchlässigkeit

und Flußrichtung der freien Elektronen vorgegeben

sind. Natürliches Licht ist nicht monochromatisch,

dh es besteht aus Wellenpaketen verschiedenster Wellenlängen,

die das Auge als Farben wahrnimmt. Kürzere Wellenlängen reichen

nicht sehr tief in die Materiallschicht und werden

stärker reflektiert, wärend größere

Wellenlängen mehr unter der Oberfläche (Diffusionsschicht,

n-dotierter Bereich) ihre Energie abgeben. Diese Eigenschaft

führt dazu, daß eine PD unterschiedlich

auf die verschiedenen Wellenlängen des Lichtes

reagiert und keine lineare Charakteristik zeigt, die

durch die Halbleiterbeschaffenheit (Materialauswahl,

Dotierung, Betriebszustand) beeinflußbar ist.

Die "Sehfähigkeit" der PD erfolgt durch

den jeweils verursachten Ladungstransport im Sinne

von Stromfluß und Spannungsänderung, denn

jedes Photon erzeugt im Idealfall ein frei fließendes

Elektron.

Viele Photonen erzeugen viele freie Elektronen und damit ein

starkes Signal, sodaß die Signalstärke ein Maß

für die Helligkeit (Intensität) ist.

Aber die PD hat leider einen "Schönheitsfehler",

sie ist temperaturabhängig. Bei steigender Temperatur

zeigt dieses Elektronenventil eine zunehmende Undichtigkeit,

die einen unerwünschten Störstrom generiert,

der sich als Signalrauschen bemerkbar macht. Diesen Störstrom

zu minimieren ist eines der Probleme, die gelöst

sein wollen. starkes

Potentialgefälle erzeugen, womit Durchlässigkeit

und Flußrichtung der freien Elektronen vorgegeben

sind. Natürliches Licht ist nicht monochromatisch,

dh es besteht aus Wellenpaketen verschiedenster Wellenlängen,

die das Auge als Farben wahrnimmt. Kürzere Wellenlängen reichen

nicht sehr tief in die Materiallschicht und werden

stärker reflektiert, wärend größere

Wellenlängen mehr unter der Oberfläche (Diffusionsschicht,

n-dotierter Bereich) ihre Energie abgeben. Diese Eigenschaft

führt dazu, daß eine PD unterschiedlich

auf die verschiedenen Wellenlängen des Lichtes

reagiert und keine lineare Charakteristik zeigt, die

durch die Halbleiterbeschaffenheit (Materialauswahl,

Dotierung, Betriebszustand) beeinflußbar ist.

Die "Sehfähigkeit" der PD erfolgt durch

den jeweils verursachten Ladungstransport im Sinne

von Stromfluß und Spannungsänderung, denn

jedes Photon erzeugt im Idealfall ein frei fließendes

Elektron.

Viele Photonen erzeugen viele freie Elektronen und damit ein

starkes Signal, sodaß die Signalstärke ein Maß

für die Helligkeit (Intensität) ist.

Aber die PD hat leider einen "Schönheitsfehler",

sie ist temperaturabhängig. Bei steigender Temperatur

zeigt dieses Elektronenventil eine zunehmende Undichtigkeit,

die einen unerwünschten Störstrom generiert,

der sich als Signalrauschen bemerkbar macht. Diesen Störstrom

zu minimieren ist eines der Probleme, die gelöst

sein wollen.

Das

Wahrnehmungsspektrum der PDs ist größer als

das des menschlichen Auges. Der Ultraviolet-Anteil ist

weniger differenziert als der besonders breite Rot- bis

Infrarot-Bereich. Die charakteristische Reaktionsfähigkeit

läßt sich mittels Halbleiterlegierung, Dotierterung

und mit optischen Filtern spezialisieren. Das sensorische

Spektrum für Rot, Grün und Blau ist durch die

Maxima der Intensitäten deutlich unterscheidbar.

Die

weiße Kurve entspricht dem idealisierten Wahrnehmungsspektrum

des menschlichen Auges, die Rot-Linie der PD zeigt

zwar im Rotbereich ihr Maximum, sie reicht aber schon

weit in die großen Wellenlängen des Infrarot-Bereiches

hinein. Die Magenta-Linie zeigt einen für Infrarot

optimierten Halbleiter. Eine normierte Summe aus R,

G und B zeigt ein charakteristisches Maximum im kurzwelligen

Rotbereich.

Wärend das

menschlich Auge das Grünspektrum (ca. 510 bis 560nm) sehr gut

differenzieren kann, liegt der optimale Bereich einer

Photodiode eher im Rotspektrum. Um diese Eigenschaft

dem menschlichen Auge anzugleichen, ist ein IR-Sperrfilter

für jede Photodiode notwendig. Für das obere

Kurzwellenspektrum wird ein UV-Filter verwendet und

jeder Hobbyfotograf weiß um die Wirkung eines

UV- oder IR-Sperrfilters.

Mit diesen Filtern wären zwar schon mal die störenden

Lichtanteile beseitigt, aber die Farbseparierung fehlt

noch und außerdem muß aus vielen PDs eine zusammenhängende

"Sehfläche" strukturiert werden.

Wie machen wir aus einer PD mit bekannten Eigenschaften

so eine zusammenhängende "Sehfläche" ? Und ein

Kamerasensor besteht aus Millionen dieser "Sehzellen" ...

Ein

Wafer

ist der Schaltungsträger für die Photodioden in Form

einer hochreinen und Millimeter-dünnen Silizium-Scheibe,

etwa 12 bis 30cm im Durchmesser. Auf so einer Scheibe entstehen

nicht nur die PDs, auf ihr wird der spätere Kamerasensor

vollständig hergestellt. Der Wafer ist soetwas wie eine

Pizzapfanne, die mit allen notwendigen Zutaten bestückt

wird - nur funktioniert der Backprozess anders und man verwendet

in der Regel winger Salamie. Ein

Wafer

ist der Schaltungsträger für die Photodioden in Form

einer hochreinen und Millimeter-dünnen Silizium-Scheibe,

etwa 12 bis 30cm im Durchmesser. Auf so einer Scheibe entstehen

nicht nur die PDs, auf ihr wird der spätere Kamerasensor

vollständig hergestellt. Der Wafer ist soetwas wie eine

Pizzapfanne, die mit allen notwendigen Zutaten bestückt

wird - nur funktioniert der Backprozess anders und man verwendet

in der Regel winger Salamie.

Im

Multilayer-Design kann auf dem Wafer eine Stapelanordnung

entstehen, die alle erforderlichen Elektronik-Komponenten

herstellt, strukturiert und kombiniert. Die einzelnen

PDs lassen sich zu einer Matrix (CCD, CMOS) zusammenschalten,

die auf der Oberfläche des Wafers positioniert

sein muß. Neben den PDs und unter der Sensormatrix

befinden sich die Baugruppen und Leiterbahnen zur

Steuerung und Verstärkung des optischen Signales,

wobei das Bodensubstrat die Trägerschicht bildet

und aus einer glasharten und nicht-leitenden Oxyd-Verbindung

besteht.

Aus dieser Idee einer PD-Matrix (CCD) sollte eigentlich "nur"

ein Daten-Speichermodul bei der Firma BELL entstehen.

Schließlich haben CCD- und die neuere CMOS-Technologie

eine vollkommen andere Richtung eingeschlagen. Die

aus Millionen PDs bestehende Matrixfläche erfüllt

die gleiche Funktion wie die Filmebene einer konventionellen

Kamera oder der Netzhautverbund des Auges mit seinen

Sehzellen.

Verschiedene

Baugruppen (ICs) oder Sensoren können in einem automatisierten

Prozess auf nur einem einzigen Wafer hergestellt werden, sodaß

die so erreichte Steigerung der Produktivität (Zeit, Kosten)

deutlich zur Senkung des Herstellungs- bzw Marktpreises beiträgt.

Die Größenordnung einzelner Komponenten liegt im einstelligen

µm-Bereich und man kann bereits in einem mm² sehr viel

Elektronik platzieren.

Ein

Wafer wird im Grundprinzip so "ähnlich"

bearbeitet und verschaltet, wie eine Elektronik-Platine.

Kleinste Baugruppen werden als stapelartige Anordnung

aufgetragen, mit Isolationsgräben getrennt und mit

Leiterbahnen verbunden. Eine kompliziertere Herausforderung

besteht in der Positionierung von darunterliegenden

Verschaltungsebenen, zwecks Maxmierung der lichtaktiven

Fläche, ein Kompromiss zwischen Photonenausbeute

und dem unerwünschten

Elektronenüberlauf, dem Crosstalk-Rauschen. Nach

jeder Baugruppenschicht wird die fertige Lage gereinigt und

erneut vorbereitet für die nächste Auftragung.

Ein Zyklus aus Schutzbeschichtung, Materialauftragung,

Abätzung und Reinigung realisiert diese Schichtbauweise

und die Arbeitsumgebung erinnert an ein futuristisches Chirurgielabor,

bewaffnet mit Computern, Mikroskopen, Chemikalien, speziellen

Lichtquellen und astronauten-ähnliche Schutzkleidung.

Tatsächlich

ist nicht nur der Herstellungsprozess

wesentlich aufwändiger, selbst die Voraussetzungen

der Herstellung (Reinraum, Prozessanlagen) sind technologisch

und finaziell nichtmal mit dem Equipmet der aktuellen

Micro-Chirurgie vergleichbar. Allein die Kontroll-

und Diagnose-Einrichtungen erreichen den Kapitalwert

von einem Einfamilienhaus. Die verschiedenen Verfahren

der Materialauftragung, der Maskenbeschichtung, der

Implementierung, der Belichtung, der Nachdotierung

und der Abätzung einzelner Areale führen

schließlich zur geplanten Baugruppen- und Verschaltungsstruktur.

Und dieser Prozess, der in klienisch reiner Umgebung

erfolgen muß, ist "nur" die letzte Fertigungsetappe

einer komplexen und zeitaufwändigen Vorbereitung.

Selbst das anschließende Auseinanderbrechen

der einzelnen Chipareale verlangt Hightec-Präzision

(von Laserstrahl- bis zu micro-mechanischen Schnitt-Werkzeugen)

und die Bruchstücke stellen den Sensorchip

zur Verfügung, der anschließend durch mikroskopisch

feine Goldfäden mit seiner Fassung verbunden

(Bonding-Verfahren)

wird. Die Fassung muß die notwendige

Kontaktierung (pins, beads/balls, springs, auch:

SMD, BGA) nach außen herstellen.

[ weiter ... ]

|