IMAGE PROCESSING

Die

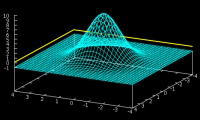

statische Rauschunterdrückung (Pattern-Noise)

resultiert aus einer sensorcharakteristischen Maske,

die fehlerhafte oder übersteuernde Pixel markiert.

Auf die markierten Pixel wird dann ein justierter

Gaussfilter angewendet, um das lokale Defektrauschen

zu eliminieren.

| |

|

+ |

|

Einige hochwertige

Kamerasysteme verfügen optional über eine automatisierte

Defekt-Pixel-Filterung, entweder per Periferie-Software oder seltener

auch per Hardware. Zur Beseitigung der permanent übersteuernden

oder defekten Pixel wird die Maske und der Operator eigenständig

vom System justiert, wobei die generierte Maske die XY-Koordinaten der

Defekt-Pixel lokalisiert und die Periferie den Wert in eine Log-Datei

speichert.

Für

das interne Image-Processing haben wir jetzt alle notwendigen

Filter zusammen: 1.) Black/White-Balance, 2.) Gamma- und

3.) Farbkorrektur, 4.) Gradientenfilter, 5.) Sharpen-Filter

und 6.) den Noise-Reduction-Filter. Die Wirkung dieser

Filter, vom Original ausgehend, sieht dann so aus:

Original: Hektische Betriebsamkeit im Ministerium für

Technologie und Wissenschaft

White-Balance bzw. Gamma-Korrektur

Farbkorrektur (Magenta, Yellow, Cyan) - am gelben Hintern

kann man die politische Gesinnung erkennen.

einfacher und unlimitierter Gradientenfilter

Sharpenfilter auf L-Kanal (LAB-Format) ohne Gradient angewendet

Gaussfilter als Noise-Reduction ohne invert Gradient

Die

analoge Bildverarbeitung verfügt theoretisch zwar

über einige dieser Filter, aber sie erreicht nicht

annähernd die exakte Lokalisierung einer digitalen

Berechnung. Die analogen Filterprozesse, die zur Optimierung

der Bildqualität notwendig sind, können nur

beim Entwicklungsprozess oder bei der Zweitbelichtung

im Labor angewendet werden. Der Signalweg durchläuft

im Vergleich mehrmals die optischen Instrumente, er ist

also länger und somit mit mehr Fehlern behaftet.

Den einzig verbleibenden Vorteil, den ein analoges Positiv

oder Negativ noch halten kann, ist die hohe Dynamik. Selbst

stark differierende Hell-Dunkelzonen verkraftet ein hochwertiges

Analog-Negativ immer noch besser als die meisten Digital-Kameras.

Bei

nicht beweglichen Motiven gibt es für dieses

Dynamik-Problem das HDR-Verfahren (High Dynamic Range),

das aus verschieden belichteten Bildserien ein ausgleichendes

Abbild errechnet. Bisher (2007) hat nur der Hersteller

Fuji einen Sensor (EXR-CCD)

entwickelt, der speziell dieses Problem durch versetzt

positionierte PD-Arrays berücksichtigt, ohne

auf ein zeitaufwändiges HDR-Processing rückgreifen

zu müssen.

Das

Prinzip besteht aus der gleichzeitigen Belichtung von

zwei unterschiedlich lichtempfindlichen Zellen-Arealen.

Ein Areal liefert eine starke Belichtung (+1.5BW), das

andere eine entsprechend schwache (-1.5BW). Der anteilige Mittelwert

aus beiden wäre eine neutrale Belichtung. Die extrema-ausgleichende

Berechnung entspricht der Wirkung des HDR-Verfahrens.

Dieses Verfahren funktioniert jedoch sowohl bei statischen

wie auch bei schnell bewegten Objekten.

Bei der rasanten Entwickungsgeschwindigkeit im Bereich

Materialforschung, Chipdesign und bei immer noch stetig

wachsender Integrationsdichte, wird dieser noch verbleibende digitale Nachteil

gegenüber dem Analogfilm in den nächsten

Jahren von allen großen CCD/CMOS-Herstellern

behoben sein. Der Dynamikbereich der PDs bietet

heute schon Lösungsansätze, die nicht aus

einem unvorteilhaften Kompromiss zwischen Dynamik

und Auflösung bestehen. Neuere Sensork-Konzepte,

wie etwa der FOVEON

X3, befinden sich ebenfalls mitten in der Entwicklung

und man kann davon ausgehen, daß sowohl Layout

wie auch Herstellungstechnolgien weitere Qualitätsvorteile erschließen können.

Das fundamentale Image-Processing hat

also die Aufgabe eine Bildmatrix so aufzubereiten, daß die Vorteile der jeweiligen Hardware

optimal genutzt und die Systemfehler informationserhaltend korrigiert werden können, um so die

maximal mögliche Bildqualität zu erreichen. Der nächste Schritt im Bereich

Image-Processing wäre die spektrale Bildanalyse, die Intensitäts- und Farbanalyse, die

diagnostische Objekt-Identifikation und die perspektivische 2D- und 3D-Metrik. Korrekturen der

optischen Instrumente, das Suchen nach markanten Strukturen in Bildserien, die schnelle und

präzise Kontrolle bei Fertigungs-Prozessen, die Meßtechnik besonders in den

Naturwissenschaften oder die perspektivische Navigation sind nur einige Beispiele der

praktischen Anwendung.

Diese Kurzinfo ist nur der

Anfang vom Einstieg und soll zur Orientierung für die experimentelle und

praktische DIP-Anwendung beitragen. Es gibt noch viel zu entdecken.

Mehr zum Thema ist u.a. in den Sirius5-Archiven

zu finden. md-014, nvs-067

[ KL ] |